Pour obtenir les résultats que nous voulons d’un système, ou bien pour l’empêcher de générer des événements imprévus, nous devons comprendre comment il fonctionne et se comporte en réalité. C’est exactement ce que fait le Jidoka.

Les erreurs – appelons-les « événements indésirables » – suivent habituellement le même schéma et leur analyse identifie généralement trois coupables évidents :

• une pièce ou un équipement défaillant,

• une personne qui fait mal son travail à cause de mauvaises hypothèses ou d’incompréhensions,

• une information perdue, mal dirigée ou simplement fausse.

Les deux derniers événements défavorables que j’ai pu observer dans un hôpital étaient un problème cardiaque qui n’a pas été détecté car la machine ECG était défaillante, et un patient en psychiatrie a été transféré en cellule psychiatrique avec une pneumonie qui s’aggravait parce que son psychiatre le croyait toujours en pleine forme suite à sa dernière visite trois mois auparavant, et n’a pas pensé à vérifier ses paramètres biologiques. Dans ces deux cas, l’information était présente dans le système, mais n’est pas parvenue à ceux qui prennent les décisions.

Pour trouver la défaillance, il faut rejouer patiemment chaque événement et tenter de repérer quand le réel s’écarte de l’attendu – ce qui est relativement simple après-coup, mais extrêmement difficile à anticiper parce qu’il est impossible de savoir à l’avance quelle variation aura quel effet. Insister sur le respect de chaque procédure à la lettre aboutit généralement à une situation d’enlisement où il ne se passe plus rien du tout, où chaque étape prend un temps infini et génère une souffrance atroce. D’un autre côté, les procédures ont leur utilité et on ne sait pas toujours quel écart peut avoir des effets catastrophiques.

Cependant, lorsqu’on se pose la question du « pourquoi » les choses ont tourné au vinaigre, les réponses sont immédiatement plus équivoques.

Peu de personnes commettent de vraies violations – mal faire de manière délibérée pour leur propre gain. En général, les gens font des erreurs, à l’instar de pièces qui cassent sous l’usure, et les informations ne circulent plus. On incrimine souvent la « culture » ou le « système », tous les deux dirigés par des leaders incompétents, immoraux ou négligents, et qui ont de façon répétitive ignoré les appels à travailler plus sur la sécurité ou ont poussé si fort les personnes sur la performance que ces mêmes personnes, à juste titre, ont été amenées à prendre des raccourcis, et bam.

De telles explications systémiques sont indéniablement vraies dans certains cas et il existe des cas documentés de cultures toxiques favorisant des managers toxiques. Il peut aussi y avoir des cas de harcèlement pour que les gens fassent les mauvaises choses, mais les mauvaises choses arrivent aussi quand la culture n’est ni particulièrement mauvaise, ni obnubilée par la performance. Les explications au niveau de la culture sont captivantes, mais rarement utiles puisque personne ne sait réellement comment changer les cultures autrement qu’en changeant les leaders – et même cela a des effets inattendus et incontrôlés (la culture dévore la stratégie – et le leadership – au petit-déjeuner, si l’on peut dire).

Quelle sorte d’entre-deux pourrions-nous construire pour expliquer l’échec ? Si nous mettons de côté les explications du type « la pièce est défectueuse, la personne est incompétente et la culture », comment pouvons-nous élaborer un raisonnement sur les événements indésirables qui éviterait les deux extrêmes ?

Nous pouvons tout d’abord reconnaître que les systèmes sont par certains aspects mécaniquement orientés vers des objectifs – en tout cas, ils sont conçus ainsi. Deuxièmement, les processus d’un système sont toujours actionnés en fonction d’un contexte, dans des conditions locales, qui peuvent aller du « sous contrôle » (loin de la crevasse) à « hors de contrôle » (à un pas du chaos complet), et ces conditions locales ont une influence significative sur la performance du système. Au bout du compte, les humains sont des agents doués de volonté: ils agissent de leur propre chef, en fonction de ce qu’ils pensent, et choisissent de s’impliquer ou non, d’exprimer ou pas leurs intuitions ou leurs sentiments, d’agir ou pas. En observant comment ces facteurs convergent, nous pouvons dépeindre une image de ce qui s’est passé.

Les systèmes humains se comportent rarement comme ils ont été pensés, mais ont néanmoins été pensés. Un service d’urgence est conçu pour prendre en charge des patients en termes d’urgence et de type de pathologie. Il n’est pas conçu pour absorber de grandes variations à l’entrée, contrairement aux supermarchés, où les caisses peuvent être ouvertes ou fermées en fonction de la taille des queues. Les systèmes ont une dimension mécanique de « processus » qui leur permet d’accomplir un ou deux objectifs principaux, au prix d’une longue liste de contraintes, comme des réglementations, des budgets, et des ressources disponibles. Le système est fait pour gérer des cas génériques et pour satisfaire sa population de clients de manière globale – cela signifie également que les systèmes sont rarement conçus pour s’occuper de vous et de vos spécificités. Il est peu probable que le personnel des urgences prenne en compte le fait que vous ayez un avion à prendre.

Les systèmes s’appuient sur des hypothèses de base. Ils ont des buts et des objectifs. Ils ont des processus définis et des activités pour atteindre ces buts. Ils ont des points de contrôle, pour s’assurer que les performances, réglementations et processus sont menés en accord avec les standards. Ils sont conçus pour les cas moyens dans des conditions moyennes, avec des procédures spécifiques pour gérer les circonstances spécifiques (ce qu’ils font rarement bien).

Pour comprendre comment le système fonctionne, nous pouvons commencer par définir son point de réglage mécanique : ce qu’il va essayer d’obtenir dans n’importe quel circonstance – que cela soit approprié ou non.

Deuxièmement, les systèmes sont activés dans des conditions locales. Bien que le système soit conçu pour des circonstances moyennes, très régulièrement, la vraie vie prend le pas, et les conditions ne sont pas celles qui étaient attendues. Les conditions ne peuvent pas être systématisées (ni intégrées dans la mécanique du système) précisément parce qu’elles varient. Il est nécessaire de s’appuyer sur l’expérience et la perspicacité humaines pour interpréter les conditions : est-ce que c’est un jour normal ou anormal ? Est-ce que le médecin en chef était de bonne ou de mauvaise humeur ? Est-ce que la situation est claire ou y a-t-il tant de choses qui se passent à la fois que tout le monde est confus ? Les experts qui comprennent ces conditions sont-ils rapidement disponibles ou est-ce que les gens sont livrés à eux-mêmes pour prendre des décisions ? Est-ce qu’il y a une culture d’attentes fortes ou faibles ? Et ainsi de suite, les questions peuvent être infinies. Les conditions locales se traduisent tout d’abord par de la friction : des difficultés à réaliser l’étape du processus à cause d’une ambiguïté, du hasard, de l’incertitude, ou simplement d’un part d’entropie et tous les aléas qui font que la réalité mette en échec n’importe quel processus. La friction est la clé pour comprendre les conditions locales plutôt en dépit d’idées préconçues, parce que la friction est reconnaissable, et il est possible de demander quelles conditions créent cette friction.

De façon locale, la friction peut amener à de la redéfinition : les personnes adaptent le système aux conditions locales pour leur propre usage. Par exemple, la maintenance d’un même type d’équipement peut largement varier selon les conditions locales : à quelle distance ils se trouvent du fabricant et à quel point est-il facile d’obtenir un coaching d’un expert ou de la formation locale, à quel point le manager local est-il intéressé à réellement dépenser le budget de maintenance sur la maintenance, ou bien est-il en train de l’utiliser pour autre chose, etc. La redéfinition du système est une adaptation aux conditions locales, là où les personnes changent les buts, juste pour s’en sortir.

La redéfinition est normalement graduelle – elle n’arrive pas tout d’un coup, mais plutôt comme une déviation lente alors que les personnes se heurtent aux conditions locales et acceptent progressivement les conditions anormales comme normales. L’habituation est une faculté caractéristique des humains, et les personnes finissent par s’habituer à tout et cessent de réagir aux situations qu’ils savent intolérables, mais qui sont devenues routinières.

En partant de la friction pour aboutir à la redéfinition, les conditions locales sont le second élément qui peut aider à comprendre le comportement d’un système, si nous nous y intéressons d’assez près (et avec suffisamment d’ouverture d’esprit).

Troisièmement, les personnes ont des actions intentionnelles : elles interviendront intentionnellement ou, au contraire, décideront intentionnellement de ne pas intervenir. Le silence ou la violence sont des réactions typiques au conflit et à la frustration, et on peut s’attendre à des réactions très différentes à la même situation. « Ne pas utiliser le téléphone au volant » est une règle simple et une évidence en terme de sécurité, et pourtant les personnes l’interpréteront très différemment en fonction de la façon dont ils se perçoivent, de leur identité, de la perception de leur propre personnage, en fonction de leur concentration sur le moment et de la logique de la situation à leur yeux (longue portion de route, trafic lent, etc.) et aussi selon leur état émotionnel – qu’ils soient concentrés sur leur conduite, qu’ils s’ennuient à mourir, ou paniqués par un problème urgent qui doit être résolu à l’instant, par exemple.

Nous sommes par nature des créatures de sentiments mélangés. Ce que nous voulons change d’un moment à un autre. Notre perception de la situation peut changer du matin au soir. Ce n’est pas un hasard si la plupart des anciennes philosophies cherchaient des moyens d’atteindre une forme de paix – nos esprits ne sont pas construits pour cela. Dans notre monde actuel de machines et de systèmes, nous traitons souvent les gens comme s’ils étaient des machines eux-mêmes, qui suivent une série d’instructions et de processus comme des robots, mais cela nécessite une pression extrême – ce n’est simplement pas comme cela que les gens réfléchissent et se comportent. Il n’y a pas un moyen unique de décrire la complexité du comportement humain, la motivation et la prise de décision, mais en dépit d’un meilleur système nous continuons à le décrire en trois parties antiques : le pathos, le logos et l’éthos :

● Pathos : comment la personne réagit-elle à ses émotions ? Est-elle calme et raisonnée, pèse-t-elle les arguments et considère-t-elle les perspectives ? Ou est-elle dans l’émotion, et réduit-elle la situation à ce qu’elle a besoin de faire dans l’instant, de manière impulsive et instinctive, selon son humeur et son expérience subjective de l’instant ? La même personne réagira très différemment selon son état émotionnel (se sent bien/ne se sent pas bien) et à l’intensité de celui-ci (se sent calme/dans l’émotion).

● Logos : Quelle est la robustesse de sa logique ? Selon sa compréhension de la situation (et la force de ses émotions et intuitions), la personne peut faire aussi bien des analyses de cause à effet logiques – et son comportement la mènera logiquement vers un objectif attendu en se basant sur les faits – que des affirmations farfelues et des « actes de foi » intuitifs basés sur des hypothèses bancales.

● Ethos : A quel point la personne est-elle en général responsable et digne de confiance ? On peut compter sur certaines personnes plus que sur d’autres pour assumer la responsabilité et faire ce qui est le mieux pour le groupe, encourager la coopération et le soutien mutuel, au lieu de laisser les autres tomber en faisant ce qui est mieux pour soi-même dans l’instant – agir de façon impulsive ou négligente, ne pas exécuter des tâches ou des consignes comme promis, pour ensuite blâmer les autres pour leur insuffisances. Peut-on en général compter sur ces personnes – ou non ?

Avec en tête ces trois éléments de contexte, nous pouvons aller au-delà de l’analyse « mauvaise pièce, erreur humaine, mauvaise information » des incidents et nous intéresser plus profondément à:

1) Dans quelle mesure le système s’est-il éloigné de son état normal ?

2) Quelles étaient les conditions locales spécifiques ?

3) Qui étaient les personnes présentes et comment ont-elles réagi ? Ont-elles choisi d’intervenir ou pas ? Leur intervention était-elle pertinente ou pas ?

Vu sous cet angle, nous pouvons voir qu’un quatrième élément a une influence critique sur les résultats : quel est le niveau de compréhension des personnes sur la manière dont le système fonctionne ? La connaissance du système, de son état normal et de la manière dont il réagit dans différentes conditions, aura un impact considérable sur l’environnement émotionnel et la logique des réponses. Si les gens savent ce que le système fait, ils se sentiront davantage capables d’intervenir de manière judicieuse afin d’éviter (ou d’atténuer) un accident.

Dans la plupart des incidents que j’ai vus à l’hôpital, les médecins et infirmières ne savent souvent pas comment les systèmes informatiques et administratifs fonctionnent, et quand ils décident d’intervenir, ils appliquent un contournement qui peut aggraver la situation – ou à l’inverse ignorer quelque chose qui devrait être fait. Dans un hôpital classique, les infirmières isolent rarement un équipement au premier signe de dysfonctionnement et s’acharnent à essayer de faire fonctionner le système malgré tout. Elles sont constamment en surcharge et savent que n’importe quelle action de maintenance est susceptible de prendre du temps, et du coup elles vont continuer à utiliser l’équipement jusqu’à ce qu’il tombe totalement en panne – et par là même ajouter de l’incertitude et du risque. Elles ont généralement un modèle mental très vague de la vitesse à laquelle l’équipement se dégrade (ou quel est l’impact sur le patient d’une erreur mineure de mesure) et de ce qu’il faut faire pour réparer ou remplacer l’équipement.

Des théories erronées sur la façon dont les choses fonctionnent amènent à des réactions tant illogiques que émotionnelles, car les personnes se sentent plus menacées par la situation et réagissent de manière plus intuitive – un scénario classique vers des effets indésirables. Ce que les personnes connaissent des systèmes qu’elles utilisent a un impact significatif sur les conséquences au moment où le système se met à dériver.

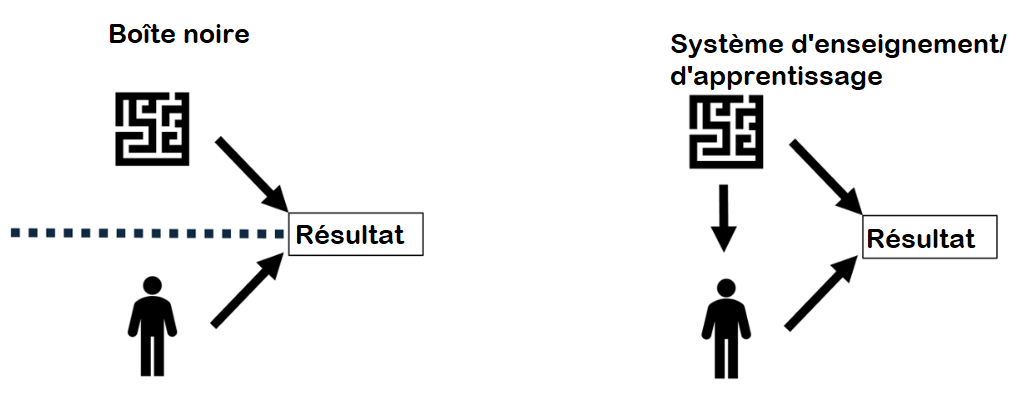

En conséquence, les systèmes peuvent être conçus de deux façons : soit comme une boîte noire dans laquelle l’utilisateur n’a aucun moyen de comprendre comment le système fonctionne – comme la plupart des système complexes de nos jours – soit comme un dispositif d’apprentissage où l’utilisateur a accès à l’intérieur du système afin de le comprendre tout en l’utilisant. Nous avons vu évoluer les systèmes d’apprentissage, dans lesquelles les propriétaires de voitures pouvaient réparer des choses basiques dans leurs automobiles, à des boîtes de plus en plus noires conçues pour éloigner le conducteur – et en fait de plus en plus souvent le mécanicien également – du moteur.

Les boîtes noires plaisent aux concepteurs de systèmes car ils imaginent – certainement à raison – que moins les personnes bricolent le système, plus il y aura de chances qu’il accomplisse son comportement de base. L’hypothèse, ici, est d’utiliser un système jusqu’à ce qu’il casse, et puis appeler la maintenance ou le remplacer. Cette hypothèse, cependant, ne prend pas en compte tous les états intermédiaires dans lesquels se trouvent les utilisateurs lorsque le système ne se trouve ni dans ses conditions de base ni complètement cassé – exactement le cas où l’action peut empêcher un désastre si tant est que les utilisateurs sachent quelle action prendre.

Les systèmes jidoka, avec des outils comme l’andon, sont conçus pour éduquer les utilisateurs. Depuis le métier à tisser automatique de Sakichi qui s’arrêtait lorsqu’un fil de coton cassait jusqu’aux usines d’aujourd’hui dirigées par l’andon, de tels systèmes sont faits pour détecter leurs propres anomalies, s’arrêter et appeler un utilisateur pour qu’il puisse examiner et remplacer le composant défectueux (ou former à nouveau l’opérateur). De tels systèmes enseignent aux utilisateurs à mieux connaître la façon dont ils fonctionnent et à en construire une image mentale plus précise, en ayant l’expérience de leur fonctionnement, tant dans les conditions normales que dans différents contextes dégradés.

Alors que les systèmes deviennent plus complexes et sophistiqués à chaque nouvelle technologie, les concepteurs de systèmes doivent se poser une question supplémentaire : dans quelle mesure l’utilisateur doit-il se familiariser avec le système ? Nombre de managers sont désormais chargés de faire fonctionner des systèmes incroyablement complexes auxquels ils prennent également part, et qui ont été conçus comme des boîtes noires. Les managers sont désormais formés à suivre les processus, pas à comprendre les comportements des systèmes, et plus spécifiquement pas les comportements de leurs systèmes. Par conséquent, bien que les systèmes soient de plus en plus sophistiqués, les conséquences sont partout remises en cause – et il est certain que la logique de l’action et du contrôle par l’humain s’amenuise rapidement.

Le jidoka du Lean a plus à apprendre au monde que de simple moyens de détrompage ou de manières intelligentes de détecter les problèmes avant qu’il n’apparaissent. Il s’agissait au départ d’équiper les machines avec certains aspects de l’intelligence humaine – plus précisément, reconnaître une bonne pièce d’une mauvaise ou un composant usagé d’un valide. Mais dans le même temps, le jidoka (repérer chaque défaut, notifier chaque défaut, réagir immédiatement et corriger la situation) change également la relation humaine avec les systèmes : cela crée des systèmes d’apprentissage/d’enseignement dans lesquels les personnes peuvent mieux comprendre comment le système fonctionne et se comporte dans la réalité, et quoi faire pour atteindre les résultats qu’ils recherchent. Dans chaque système complexe comme un hôpital ou une usine où les comportements intentionnels impactent la sécurité, nous avons besoin de comprendre davantage, et pas moins comment le système fonctionne – pour le rendre plus sûr.

Michael Ballé

Article original publié sur Planet-Lean.com. Traduit par Marc-Antoine Guichard, Nicolas Villemain et François Lopez

Téléchargez le pdf